Quels sont les enjeux juridiques de l’utilisation de l’intelligence artificielle dans les diagnostics médicaux en entreprise ?

L’intelligence artificielle dans le domaine de la santé : un outil révolutionnaire

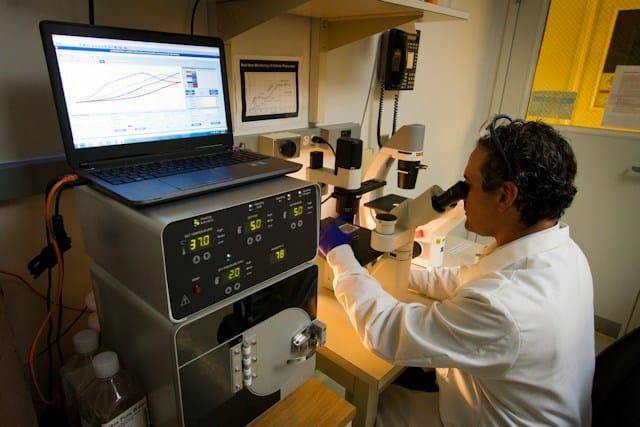

L’intelligence artificielle (IA) est de plus en plus présente dans notre quotidien et touche désormais le secteur de la santé. Sa capacité à analyser rapidement un grand volume de données en fait un outil précieux pour les professionnels de la médecine. Dans le contexte de l’entreprise, elle permet d’optimiser le travail médical par un diagnostic plus rapide et plus précis. Mais à quel prix ?

L’utilisation de l’IA dans le secteur médical offre de nombreux avantages. Elle permet d’analyser rapidement les symptômes des patients et d’établir un diagnostic en un temps record. Elle facilite également le travail des médecins en leur fournissant des informations précises et actualisées. Mais cette nouvelle technologie soulève également plusieurs questions juridiques et éthiques.

A découvrir également : Quelles sont les implications légales de la gestion des droits d’auteur pour les plateformes de streaming musical ?

Les enjeux juridiques de l’utilisation de l’IA dans le domaine médical

L’IA est un système qui peut prendre des décisions sans intervention humaine. Elle est capable d’analyser des données et de prendre des décisions basées sur ces analyses. Mais quelle est la responsabilité juridique de ces systèmes en cas d’erreur de diagnostic ? Qui est responsable si le patient subit des dommages à cause d’une erreur de l’IA ?

La question de la responsabilité est au cœur des débats juridiques autour de l’IA. Si une erreur de diagnostic est commise par un système d’IA, la responsabilité peut-elle être attribuée à l’entreprise qui a conçu le système, au médecin qui a utilisé l’IA ou au système lui-même ?

Lire également : Avocat expert en cession fonds de commerce à lyon

Le droit actuel ne prévoit pas de cadre spécifique pour l’IA. Les règles applicables sont celles du droit commun, ce qui pose plusieurs problèmes. D’une part, l’IA n’est pas une personne physique ou morale, elle ne peut donc pas être tenue responsable. D’autre part, la responsabilité du médecin pourrait être engagée, mais cela semble injuste si l’erreur est due à un défaut du système d’IA.

Les droits des patients face à l’IA

Les patients ont également des droits lorsqu’ils sont diagnostiqués par l’IA. Ils ont le droit de connaître le processus de prise de décision utilisé par l’IA et d’être informés des risques associés à son utilisation. Mais comment garantir ces droits dans un monde où l’IA est de plus en plus présente ?

L’IA est un système complexe qui utilise des algorithmes pour analyser les données et prendre des décisions. Il est donc difficile pour un patient de comprendre comment l’IA a pris une décision. De plus, l’IA n’est pas capable d’expliquer ses décisions de la même manière qu’un humain.

Le droit à l’information du patient est donc mis à mal par l’utilisation de l’IA. Pour garantir ce droit, il serait nécessaire de développer des outils permettant de rendre les décisions de l’IA plus transparentes et compréhensibles pour les patients.

L’IA et le respect de la vie privée des patients

L’IA a besoin d’un grand volume de données pour fonctionner. Dans le domaine de la santé, ces données sont souvent des informations médicales sensibles. Qu’en est-il du respect de la vie privée des patients dans ce contexte ?

L’IA est capable de traiter et d’analyser un grand volume de données médicales. Cela lui permet de fournir des diagnostics précis et rapides. Mais cette capacité pose également des problèmes en termes de respect de la vie privée.

En effet, l’IA doit respecter les règles de confidentialité des données médicales. Ces règles sont encadrées par la loi, qui prévoit des sanctions en cas de violation. Toutefois, l’utilisation de l’IA pourrait faciliter l’accès à ces données par des tiers, ce qui pose des questions sur la sécurité des données médicales.

Vers une régulation de l’IA dans le domaine médical ?

Face à ces enjeux, une régulation de l’utilisation de l’IA dans le domaine médical semble nécessaire. Mais comment mettre en place une telle régulation ?

Une régulation de l’utilisation de l’IA dans le domaine médical pourrait passer par la mise en place de normes et de contrôles spécifiques. Cela permettrait de s’assurer que l’IA respecte les droits des patients et les règles de confidentialité des données médicales.

Cette régulation pourrait également prévoir un cadre juridique spécifique pour l’IA. Cela permettrait de clarifier les questions de responsabilité en cas d’erreur de diagnostic et de garantir le droit à l’information des patients.

L’IA est un outil précieux pour le domaine médical. Mais son utilisation soulève des questions juridiques et éthiques importantes. Il est donc nécessaire de mettre en place une régulation adaptée pour garantir le respect des droits des patients et la responsabilité des acteurs impliqués.

L’utilisation de l’IA et la protection des données à caractère personnel

L’intelligence artificielle est un formidable outil pour l’analyse et le traitement des données de santé. Toutefois, elle soulève des préoccupations majeures en matière de protection des données à caractère personnel. Comment garantir la confidentialité et la sécurité des données médicales dans ce contexte ?

L’IA a besoin d’accéder à une grande quantité de données santé pour fonctionner de manière optimale. Ces informations peuvent inclure des détails très personnels sur l’état de santé des individus, leur historique médical, leurs habitudes de vie, etc. Ces données sont sensibles et leur divulgation non autorisée peut avoir des conséquences graves.

La protection des données est un enjeu crucial dans le cadre de l’utilisation de l’IA dans le domaine de la santé. Elle est régie par des réglementations strictes au niveau national et international, notamment le Règlement général sur la protection des données (RGPD) de l’Union européenne.

Toutefois, garantir la protection des données dans un contexte d’utilisation de l’IA est un défi. La quantité de données à analyser et le caractère complexe des algorithmes utilisés rendent difficile la mise en place de mesures de sécurité efficaces. De plus, l’IA étant un système autonome, elle pourrait potentiellement accéder à des informations sans le consentement des individus concernés.

Il est donc impératif de mettre en place des mesures de protection renforcées et de concevoir des systèmes d’IA qui respectent les principes de confidentialité dès la conception (Privacy by Design). Cela inclut par exemple la pseudonymisation des données, la limitation de la collecte de données au strict nécessaire, la mise en place de mécanismes de contrôle d’accès aux données, etc.

L’IA et la prise de décision médicale : le rôle des professionnels de santé

L’intelligence artificielle peut-elle remplacer les professionnels de santé dans la prise de décision médicale ? La question soulève des enjeux éthiques et juridiques importants.

L’IA a la capacité d’analyser rapidement un grand volume de données et de fournir un diagnostic ou des recommandations de traitement. Cependant, la prise de décision médicale ne peut être entièrement automatisée. Les professionnels de santé jouent un rôle crucial dans l’interprétation des résultats fournis par l’IA, la prise en compte du contexte global du patient et la communication des résultats au patient.

Dans le cadre de l’utilisation de l’IA dans le domaine médical, le professionnel de santé reste donc un acteur essentiel. Il ne peut déléguer entièrement sa responsabilité à l’IA et doit rester maître de la décision finale. Le Code de santé publique prévoit que le médecin reste le seul habilité à poser un diagnostic et à prescrire un traitement.

Par ailleurs, le rôle du professionnel de santé est également crucial pour garantir le consentement éclairé du patient. Celui-ci doit être informé de l’utilisation de l’IA dans le cadre de son diagnostic ou de son traitement, comprendre comment l’IA fonctionne et quelles sont les implications de son utilisation.

Conclusion

L’intelligence artificielle est un outil révolutionnaire qui a le potentiel de transformer le domaine de la santé. Elle offre des perspectives prometteuses en termes d’amélioration de la qualité des soins, d’optimisation de l’efficacité des professionnels de santé et de personnalisation des traitements.

Cependant, son utilisation soulève des enjeux juridiques et éthiques majeurs qui doivent être pris en compte. La protection des données à caractère personnel, le respect du consentement éclairé du patient, la responsabilité des professionnels de santé et des entreprises qui développent l’IA, sont autant de questions qui nécessitent une régulation adaptée.

Face à ces défis, il est essentiel de développer un cadre juridique spécifique pour l’IA dans le domaine médical. Ce cadre doit garantir le respect des droits des patients et des professionnels de santé, tout en permettant l’innovation et l’amélioration continue des soins de santé par l’IA.

Le développement de l’IA dans le domaine de la santé est un processus complexe qui requiert la collaboration de nombreux acteurs : professionnels de santé, chercheurs, juristes, éthiciens, entreprises de technologie, autorités de régulation, patients, etc. Il est donc crucial de favoriser le dialogue et la coopération entre ces différents acteurs pour concevoir une IA qui soit à la fois efficace, éthique et respectueuse des droits de chacun.